Chaque début d’année est un moment un peu particulier.On regarde ce qui a changé, ce qui s’est accéléré, ce qui s’est aussi parfois embrouillé. Et sur un sujet, il n’y a aujourd’hui plus aucun doute : l’IA et la data sont partout. Chez Stat4decision, nous abordons 2026 avec une conviction renforcée par les échanges, les formations et les projets menés …

Stat4decision au salon Learning Technologies France 2026

Rendez-vous stand R72 – Paris Expo Porte de Versailles les 28 et 29 janvier. À la fin du mois de janvier, Stat4decision participera au Learning Technologies France, le rendez-vous de référence pour tous les acteurs de la formation, des ressources humaines et du learning digital. Pendant deux jours, Emmanuel et Coralie seront présents sur le stand R72 du salon Learning …

Comprendre les SGBD relationnels : comparatif complet et usages

Après de nombreuses années dans l’ombre d’autres outils (python, R…), le SQL revient en force dans le quotidien du data analyst et du data engineer. En effet, on a souvent cru que le SQL n’avait plus sa place dans le monde de la data car on a confondu data science et préparation de données. De plus avec l’avènement des Data …

Les bonnes pratiques Python : écrire du code robuste, lisible et durable

Python s’est imposé comme un langage incontournable dans la science des données, l’intelligence artificielle et le développement logiciel. Mais entre un script rapide écrit dans un notebook et un projet professionnel, il existe un monde. Ce qui distingue les deux n’est pas seulement la complexité du code, mais la capacité à écrire un code robuste, lisible, maintenable et transmissible.

Apprendre les bases du SQL : un guide complet pour bien démarrer

Un article pour rappeler les principes de bases du langage SQL par des exemples de code.

Statistiques pour la prise de décision : les fondamentaux que toute organisation devrait maîtriser

Les statistiques ne sont pas réservées aux data scientists ou aux chercheurs. Dans un monde où la donnée guide de plus en plus les décisions opérationnelles, maîtriser quelques fondamentaux statistiques peut faire toute la différence entre intuition et décision éclairée.

Databricks en entreprise : comprendre l’écosystème et ses cas d’usage

Comprendre l’écosystème Databricks pour transformer vos données en valeur.

Explorez les usages concrets de cette plateforme unifiée : data engineering, machine learning, SQL, gouvernance… sans jargon ni discours commercial.

Apache Hive : maîtriser le requêtage Big Data avec HQL

Découvrez dans cet article complet comment Hive transforme vos fichiers distribués en tables SQL interrogeables, les différences clés entre HQL et SQL classique, et des exemples concrets pour créer, requêter et optimiser vos tables Big Data. Une lecture indispensable pour les data analysts, ingénieurs et architectes Big Data.

Skrub pour préparer efficacement vos données : une solution Python pour le machine learning

Besoin de nettoyer et vectoriser rapidement vos données tabulaires pour du machine learning ?

On vous présente Skrub, une bibliothèque Python développée par l’équipe derrière scikit-learn.

Nettoyage automatique, jointures floues, vectorisation intelligente : en quelques lignes, vos données sont prêtes pour vos modèles.

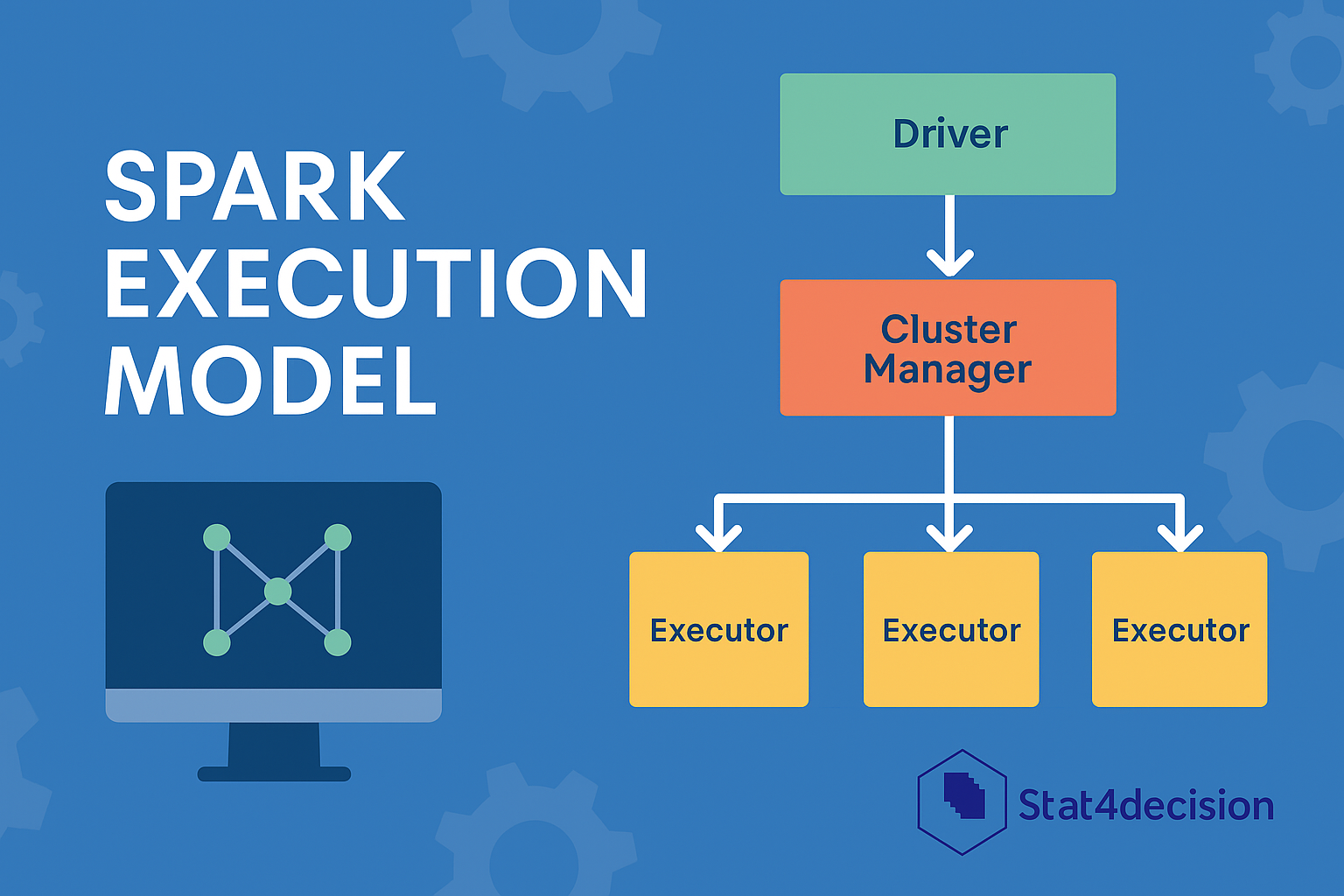

Optimisation des performances sous PySpark pour l’analyse big data

Découvrez les leviers essentiels pour optimiser vos jobs Spark : configuration, partitionnement, cache, bonnes pratiques de code… Un guide complet pour passer à l’échelle efficacement.