La classe ColumnTransformer de scikit-learn permet de traiter de manières différentes les colonnes d’un jeu de données, notamment les variables qualitatives et quantitatives.

Qu’est-ce que le nouvel opérateur morse de Python 3.8 ?

Python 3.8 se dote d’un nouvel opérateur, l’opérateur morse qui combine allocation et test.

Traitement Automatique du Langage Naturel en français (TAL / NLP)

Le traitement du Langage Naturel est un des domaines de recherche les plus actifs en science des données actuellement. C’est un domaine à l’intersection du Machine Learning et de la linguistique. Il a pour but d’extraire des informations et une signification d’un contenu textuel.

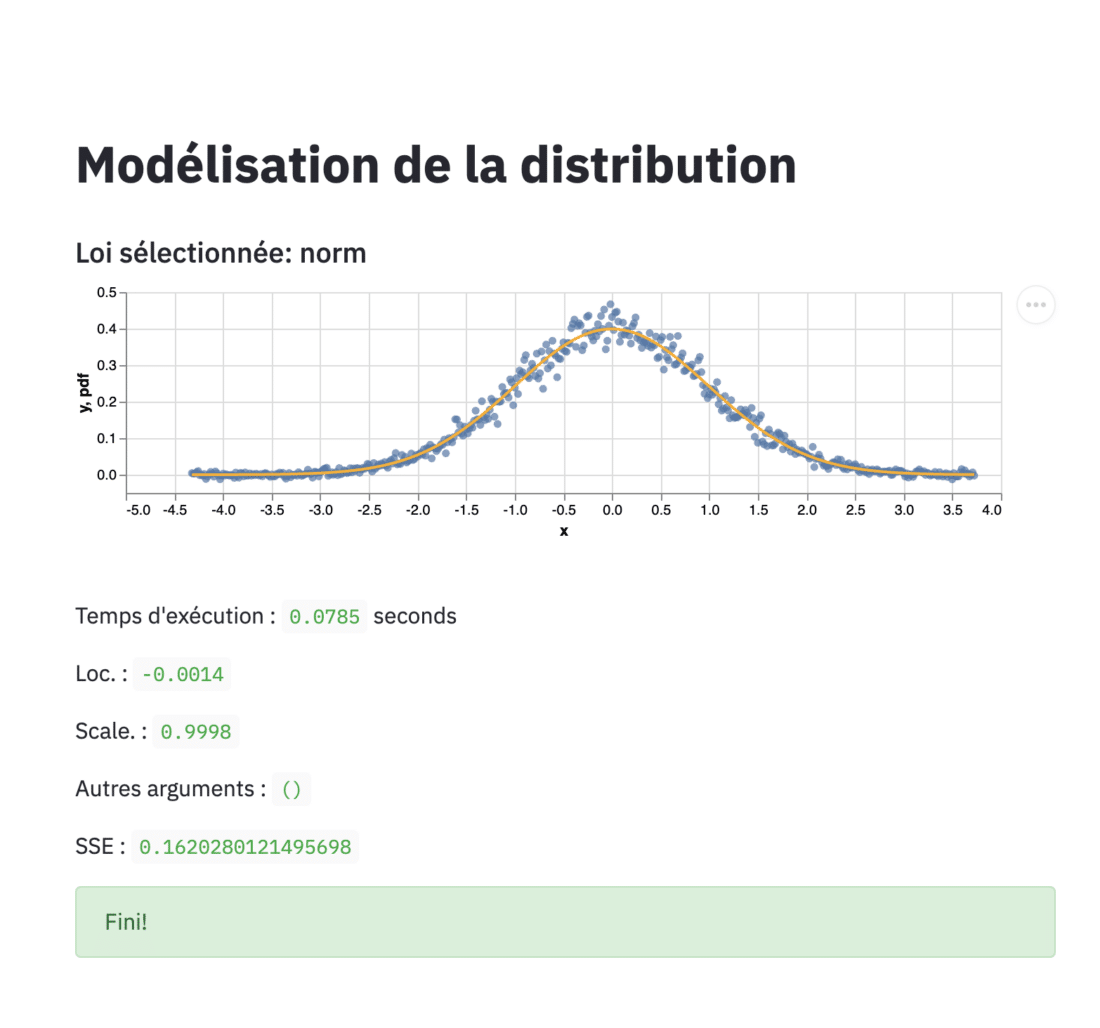

Modéliser une distribution avec Python

La modélisation de la distribution des données (distribution fitting en anglais) est le fait de trouver les paramètres de la loi de probabilité (ou de plusieurs lois candidates) qui correspond aux données que l’on cherche à modéliser. Dans cet article, nous illustrons ce concept avec un exemple en Python.

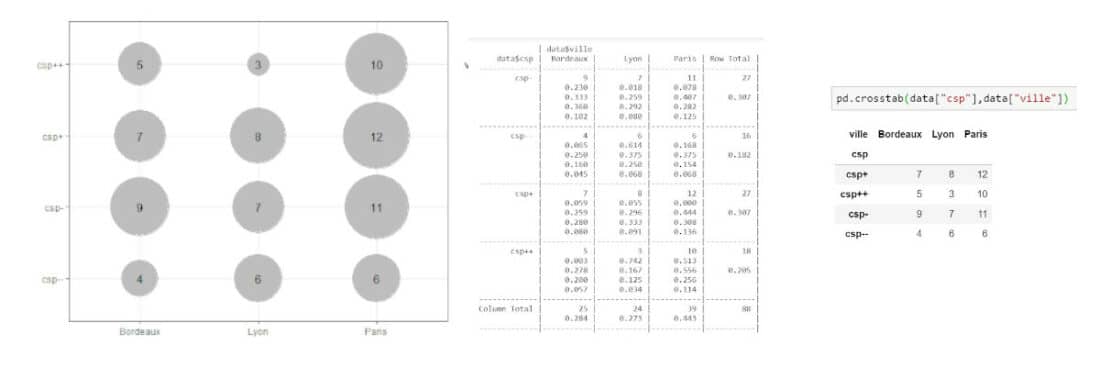

Le tri à plat et le tri croisé avec R et Python

Le tri à plat et le tri croisé sont des opérations de base pour la description des données. Nous proposons une description de ces opérations et des exemples de code en R et en Python.

Le langage Julia va-t-il remplacer R et Python ?

Le langage Julia est un langage adapté à la data science mais faut-il s’y plonger ? Quels en sont les principes ? Faisons un point sur son évolution.

Liste des packages Python pour la data science

Le langage Python a retrouvé une nouvelle jeunesse depuis quelques années grâce à l’essor de la data science.

Comme je le disais dans l’article sur les langages de la data science, Python a pris une réelle valeur grâce au fait qu’il est à la fois un langage généraliste mais aussi qu’il possède des packages Python spécifiquement adaptés à la data science. Que ce soit pour la data science, la statistique, l’analyse de données ou encore la data visualisation, Python offre une alternative intéressante à R.

Je vous présente ici une liste de packages Python extrêmement utiles pour les data scientists désirant utiliser Python.

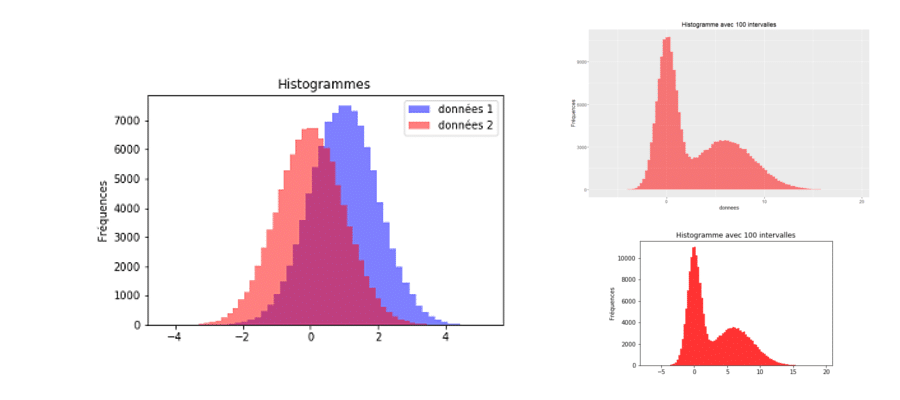

Construire un histogramme avec R et python

Cet article vous donne les clés pour construire un histogramme avec R et avec python. Détail des paramètres et des possibilités.

JupyterLab pour donner plus de pouvoir à vos Jupyter Notebooks

JupyterLab est un nouvel IDE vous permettant de coder dans différents langages en se basant sur les désormais reconnus Jupyter Notebooks (ex-Ipython notebooks).

La suite

Les licences d’utilisation en data science

Cet article fait suite à de nombreux échanges liés aux licences d’utilisation dans le logiciel libre. Même s’il s’agit d’un thème plutôt juridique il est central pour de nombreux acteurs de la data science. Je parle ici des licences liées aux outils logiciels et non des licences liées aux documents (comme Creative Commons).