Les statistiques ne sont pas réservées aux data scientists ou aux chercheurs. Dans un monde où la donnée guide de plus en plus les décisions opérationnelles, maîtriser quelques fondamentaux statistiques peut faire toute la différence entre intuition et décision éclairée.

Pourquoi les statistiques sont essentielles dans les organisations

Que vous soyez dans le marketing, les ressources humaines, la finance ou la qualité, vous êtes confronté à des données : résultats d’enquêtes, KPI, scores, retours utilisateurs, incidents, ventes… Encore faut-il pouvoir les interpréter.

Voici quelques exemples de questions courantes où les statistiques apportent une réponse objective :

- Cette baisse de performance est-elle significative ou due au hasard ?

- Quelle est la marge d’erreur de mon sondage interne ?

- Puis-je généraliser les résultats de cette étude à toute la population ?

- Quelle variable influence le plus la satisfaction client ?

- Combien d’observations sont nécessaires pour tirer des conclusions fiables ?

Les fondamentaux à connaître pour bien démarrer

Voici les piliers statistiques que tout professionnel devrait connaître, même sans background mathématique poussé.

1. Statistiques descriptives : résumer l’information

Les statistiques descriptives permettent de résumer une série de données de manière simple et compréhensible. On distingue :

- Moyenne : la somme des valeurs divisée par le nombre d’observations. Elle donne une tendance centrale, mais est sensible aux valeurs extrêmes.

- Médiane : la valeur centrale dans une série triée. Elle est plus robuste à la présence d’outliers.

- Mode : la valeur la plus fréquente.

- Écart-type : mesure de la dispersion autour de la moyenne.

- Variance : écart-type au carré, elle donne une idée de la variabilité globale.

- Étendue : différence entre la valeur maximale et minimale.

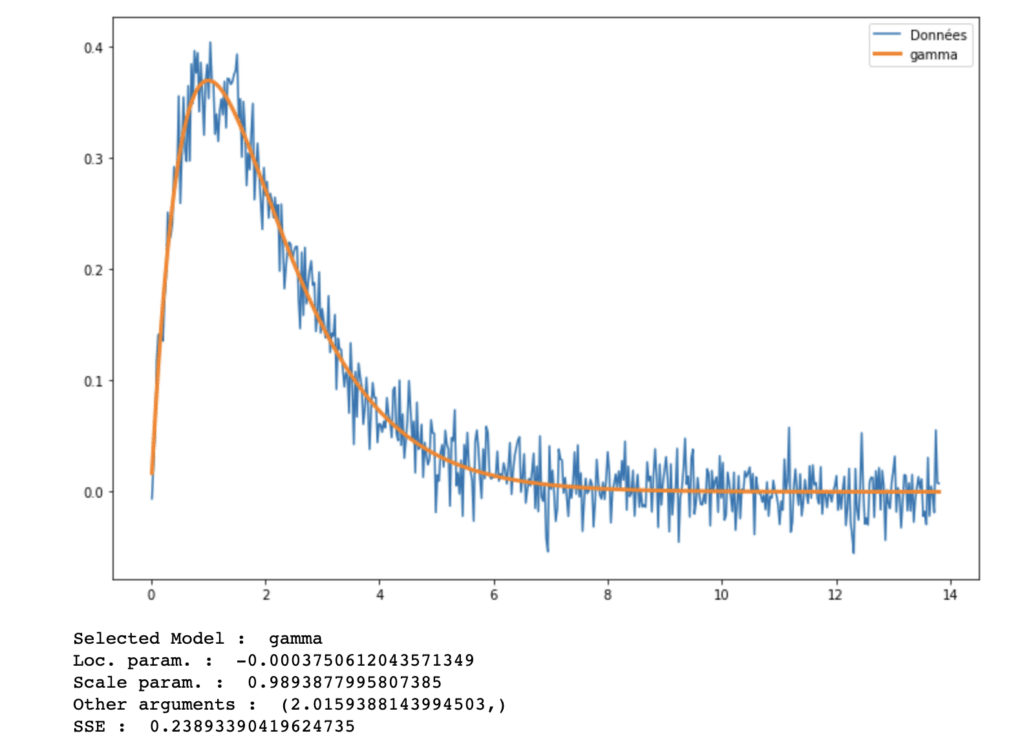

- Distribution : forme de la répartition des données (normale, asymétrique, bimodale, etc.)

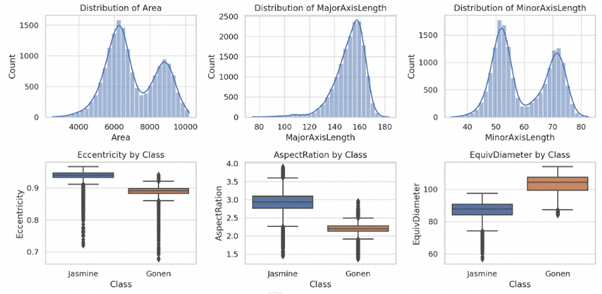

Les représentations graphiques (histogrammes, boîtes à moustaches, nuages de points) permettent de visualiser facilement ces caractéristiques.

2. Visualisation de données

La visualisation transforme des chiffres en éléments compréhensibles par tous. Elle facilite la détection de tendances, d’anomalies ou de corrélations.

- Il faut choisir un graphique adapté à la nature de la variable (quantitative ou qualitative).

- Les erreurs fréquentes incluent l’usage d’axes tronqués, l’omission de légende, ou une agrégation trop forte.

- Les outils comme Excel, Power BI, R (ggplot2), ou Python (matplotlib, seaborn) offrent de puissantes capacités de visualisation.

- Les diagrammes de Pareto permettent de repérer les causes principales d’un phénomène (loi des 80/20).

- Les cartes thermiques ou graphiques en série temporelle sont utiles pour les données évolutives ou géographiques.

3. Inférence : passer de l’échantillon à la population

L’inférence statistique consiste à généraliser les résultats obtenus sur un échantillon à l’ensemble d’une population.

- Population : ensemble complet sur lequel on souhaite conclure.

- Échantillon : sous-ensemble représentatif utilisé pour l’analyse.

- Biais d’échantillonnage : erreur introduite par un échantillon non représentatif.

- Intervalle de confiance : plage de valeurs dans laquelle on peut affirmer avec un certain niveau de confiance que se trouve la vraie valeur.

- Tests statistiques : permettent de comparer des groupes entre eux. Exemples :

- t-test : pour comparer deux moyennes

- Wilcoxon : version non paramétrique du t-test

- Chi² : pour comparer des répartitions de fréquences

- Valeur p : probabilité d’obtenir un résultat aussi extrême si l’hypothèse nulle est vraie. Plus elle est faible, plus on rejette cette hypothèse.

- Erreur de type I : rejeter une hypothèse vraie. Type II : ne pas rejeter une hypothèse fausse.

4. Régression linéaire : prédire et expliquer

La régression linéaire est un outil d’analyse prédictive et explicative.

- Régression simple : relation entre une variable indépendante et une variable dépendante.

- Régression multiple : intègre plusieurs variables explicatives.

- R² (coefficient de détermination) : proportion de la variance expliquée par le modèle. Plus il est proche de 1, plus le modèle est ajusté.

- Hypothèses de validité : relation linéaire, erreurs indépendantes, variance constante des erreurs (homoscédasticité).

- Résidus : différences entre les valeurs observées et les valeurs prédites. Ils doivent être aléatoires et sans tendance.

- Outliers : valeurs extrêmes pouvant influencer fortement les résultats.

5. Analyse multivariée : aller plus loin dans l’interprétation

Quand plusieurs variables sont observées simultanément, l’analyse multivariée permet de synthétiser l’information ou de révéler des structures cachées.

- ACP (Analyse en Composantes Principales) : réduction de dimension qui conserve l’essentiel de la variabilité. Utile pour la visualisation de données complexes.

- ACM / AFC : analyses factorielles pour les données qualitatives (profils, tableaux croisés).

- Classification (k-means, CAH) : regrouper les individus en segments homogènes selon plusieurs critères.

Ces techniques sont très utilisées en marketing, RH, qualité, ou santé publique pour repérer des profils ou simplifier la lecture de résultats nombreux.

Ce que les statistiques ne disent pas

- Les statistiques ne remplacent pas l’analyse métier : elles la complètent.

- Elles ne créent pas de données : elles permettent d’en exploiter le potentiel. Pour trouver plus de données, on peut exploiter le potentiel de l’open data / data.gouv.fr

- Elles ne donnent pas toutes les réponses, mais elles permettent de poser les bonnes questions.

- Elles doivent toujours être contextualisées dans l’environnement de collecte, sous peine d’interprétation biaisée.

Pour aller plus loin : se former aux statistiques appliquées

Vous souhaitez gagner en autonomie dans vos analyses de données ? Comme notre nom l’indique, Stat4decision est là pour utiliser les statistiques pour prendre de meilleurs décisions. Nous proposons, par exemple, une formation 100 % orientée métiers, combinant théorie accessible et exercices pratiques sur Excel, XLSTAT, R ou Python selon vos préférences.

- Formation Statistique & Analyse de données

- Niveau : initiation à intermédiaire

- Modalités : présentiel ou distanciel, 3 jours

- Public : tout professionnel confronté aux chiffres

https://www.stat4decision.com/fr/formations/formation-statistique-analyse-de-donnees/

En résumé

Les statistiques sont un outil puissant pour toute personne amenée à piloter, analyser, comparer ou convaincre. Et contrairement aux idées reçues, elles ne sont ni inaccessibles ni abstraites. Pour une liste plus complètes des méthodes, c’est ici.

Commencez par les fondamentaux — moyenne, variabilité, corrélation — et vous verrez rapidement un impact sur la qualité de vos décisions. Vous pourrez ensuite approfondir les méthodes plus complexes comme la régression, les tests statistiques ou l’analyse multivariée.

Vous pouvez aussi demander un accompagnement personnalisé ou une formation sur mesure pour votre équipe : info@stat4decision.com

Partager cet article

Comments 1

Est ce possible de suivre une formation certifiante en Statistiques pour la prise de décision ?